„Schatz, willst du an meiner Muschel lecken?“

Was sehen Kinder eigentlich auf Tiktok? Ein Experiment

Tiktok ist für Kinder und Jugendliche eines der wichtigsten sozialen Netzwerke. Doch was sehen Minderjährige auf der Plattform?

Für ein Experiment haben Studierende der TU Dortmund in Zusammenarbeit mit ZDFheute 40 Tiktok-Profile angelegt und insgesamt 3.000 Videos analysiert. Die Recherche zeigt, dass Kinder neben harmlosen Tanz- und Tiervideos auch problematische Inhalte sehen, darunter Videos, die eindeutig sexualisiert sind und fragwürdige Stereotype, Rollen- und Körperbilder vermitteln können – in einem Alter, in dem viele ihre eigene Sexualität entdecken.

Das Experiment beginnt:

Kims erste Minuten auf Tiktok

In unserem Experiment begleiten wir die fiktive Kim. Sie ist 13 Jahre alt. So alt waren auch viele der Testprofile im Versuch.

Kim hat sich gerade Tiktok heruntergeladen und geht die ersten Schritte auf der sogenannten „ForYou-Page“. Dort sieht sie Kurzvideos von anderen Nutzer*innen. Sie weiß nicht, dass sie vom Tiktok-Algorithmus ausgesucht werden.

In den ersten Minuten sieht Kim etwa Tier-, Tanz- und Musikvideos. Der Algorithmus klopft so ihre Interessen ab und belohnt, wenn Kim Videos lange schaut, auf „Gefällt mir“ drückt oder speichert. Schon in diesen ersten Minuten sieht die 13-Jährige Videos, die sexuelle Anspielungen enthalten oder intime Aspekte thematisieren – zum Beispiel dieses:

tiktok.com/@typischsasette

tiktok.com/@typischsasette

Kim sucht gezielt nach Hashtags

Kim möchte im Experiment dann aber nicht nur die Videos sehen, die Tiktok ihr auf ihrer Startseite vorschlägt. Zusammen mit ihren Freund*innen sucht sie gezielt nach Hashtags zu Themen, die ihnen gefallen – etwa #fashion, #urlaub oder #dance.

Zurück auf Kims „ForYou-Page“

Nach der Hashtag-Suche sieht Kim vermehrt Videos aus den Bereichen #fashion, #urlaub und #dance. Trotzdem sieht sie weiter Videos, die nichts mit diesen Hashtags zu tun haben; Videos wie dieses, die sexualisierte Wortspiele oder Sketche zeigen.

tiktok.com/@imsemdiary

tiktok.com/@imsemdiary

Kim reagiert neugierig auf die sexualisierten Videos, schaut sie doppelt, likt und speichert die Videos für später.

Was passiert, wenn die 13-Jährige Kim sexuelle Inhalte sucht?

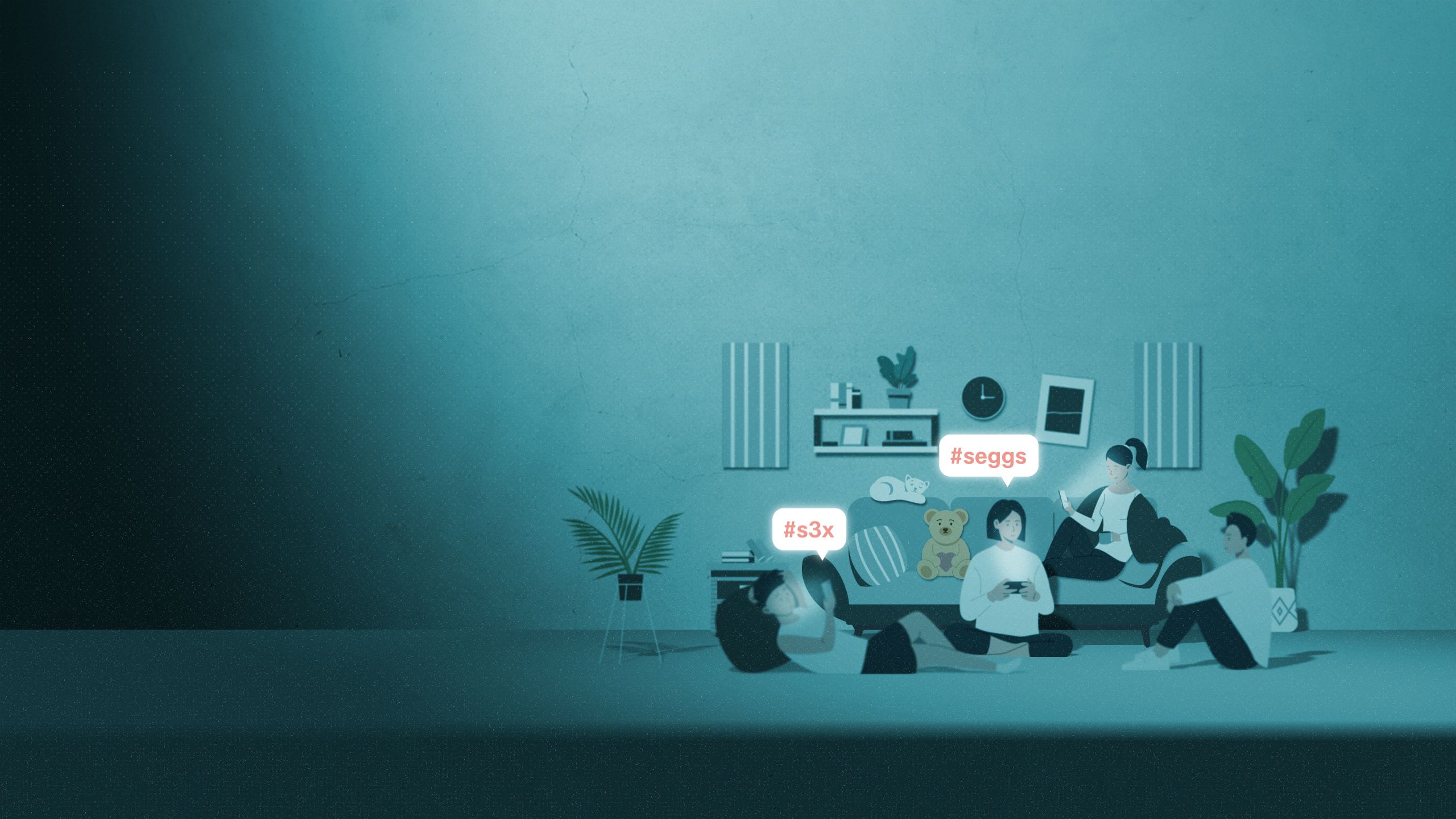

Ein Klassenkamerad erzählt Kim von Hashtags, unter denen es „richtig heftige“ Videos geben soll. Kim sucht nach diesen Hashtags, verfremdeten Begriffen für Sex, weil Tiktok das Wort blockiert. Unter diesen offensichtlich sexuellen Hashtags sieht Kim nun fast ausschließlich sexuellen Content. Sie hat als 13-Jährige nun Zugang zu Videos wie diesem, das – ohne Einordnung – unrealistische Körperideale vermittelt und eine fragwürdige Geschlechterrolle normalisiert.

tiktok.com/@Mehshaulwi

tiktok.com/@Mehshaulwi

Über die Hashtag-Suche sieht Kim ähnliche Videos, wie sie in unserem Experiment Accounts von 18-Jährigen gezeigt werden.

Kim gibt es so nicht wirklich. So wie sie Tiktok hier in den ersten Minuten erlebt hat, kann es aber vielen Kindern gehen, die sich auf der Plattform registrieren. Schon in den ersten Minuten streut Tiktok sexualisierte Inhalte in den persönlichen Feed. Und sexuelle Inhalte lassen sich über die Suche problemlos finden.

Tiktok hat bei einigen Hashtags reagiert: Die Suche nach #s3x und #seggs etwa liefert für 13-jährige Accounts keine Ergebnisse mehr. Das war während unseres Experiments noch möglich.

Unter anderen Hashtags ist allerdings weiterhin sexueller Content verfügbar. Die Frage, wie oft und nach welchen Kriterien Tiktok Hashtags sperrt, ließ die Plattform unbeantwortet.

Wie schützt Tiktok Minderjährige?

Auf ZDF-Anfrage betont Tiktok, dass die Sicherheit und das Wohlergehen von Teenagern auf der Plattform eines ihrer „wichtigsten Anliegen“ sei, „und wir wissen, dass diese Arbeit nie abgeschlossen ist“. Um Nacktheit und andere grenzwertige Inhalte zu erkennen, nutze Tiktok Technologie, aber auch Moderator*innen.

Zudem habe die Plattform im vergangenen Jahr ein System zur Einteilung von Inhalten nach „thematischer Reife“ eingeführt. Das soll nach Unternehmens-Angaben verhindern, dass beispielsweise sexuell anzügliche Inhalte ein Publikum zwischen 13 und 17 Jahren erreichen. „Darüber hinaus sind Inhalte, die eine signifikante Exposition von Erwachsenen zeigen, altersbeschränkt, und einige Formen der Körperdarstellung von Jugendlichen und Erwachsenen sind für den Für-dich-Feed nicht zulässig“, sagt Tiktok.

Grundsätzlich ist Tiktok ab 13 freigegeben. Einige Funktionen sind für die Jüngsten eingeschränkt: keine Direktnachrichten, selbst hochgeladene Videos können nur Follower*innen sehen. Um Konten jüngerer Menschen zu erkennen, nutzt Tiktok nach eigenen Angaben „eine Reihe von Strategien“. Weltweit habe man so allein im letzten Quartal 2022 17,88 Millionen Konten entfernt. Eine Verifikation des Alters findet allerdings nicht statt – User*innen können wie in unserem Experiment Profile mit falschen oder erfundenen Angaben anlegen, ohne dass Tiktok es bemerkt.

Macht Tiktok sich durch das Ausspielen sexualisierter Videos strafbar?

Rechtlich sind die im Experiment ausgespielten Videos erstmal kein Problem, sagt Michael Terhaag, Fachanwalt für IT-Recht. „Sexuelle Inhalte sind ebenso wie Pornografie nicht grundsätzlich verboten“, sagt der Experte. Keines der ihm gezeigten Videos aus dem Experiment sei seiner Einschätzung nach rechtlich relevant. Und auch ein rechtliches Fehlverhalten seitens Tiktok sieht Terhaag nicht. Trotzdem könne sich Tiktok noch mehr für den Schutz von Minderjährigen einsetzen, etwa durch Triggerwarnungen.

Die ausführliche Einschätzung des Rechtsexperten finden Sie am Ende der Story.

Unabhängig von der rechtlichen Einordnung gibt es trotzdem Bedenken bei Expert*innen, was den Einfluss der Videos auf Kinder angeht.

Für Psychologie-Professor Christian Montag ist diese Art der Konfrontation mit unterschiedlichsten Inhalten schwierig. In diesem Entwicklungszustand suchten Pubertierende noch ihre Rolle in der Gesellschaft. Problematische Inhalte könnten Rollenbilder und Stereotype vermitteln, die Montag bei Tiktok in teilweise verachtender Form wahrnimmt.

Ausreichend belastbare Studien dazu, was die Konfrontation mit sexualisierten Inhalten bei Kindern und Jugendlichen auslösen kann, gibt es bisher nicht.

Medienpädagoge Achim Lauber sieht vor allem den ungefilterten Konsum von Kurzvideos bei Tiktok kritisch: „Ich sehe jetzt nicht unbedingt, dass man solche Videos generell sperren müsste, sondern man sollte eher Eltern und Kinder irgendwie darüber aufklären und darauf vorbereiten, was sie da machen können.“

Wie viele Videos wurden untersucht?

Ein Team von Studierenden der TU Dortmund hat sich dem Jugendschutz auf Tiktok in einem nicht repräsentativen Experiment im Juni 2022 gewidmet.

Insgesamt haben sie 40 Tiktok-Profile erstellt und damit über 3.000 Kurzvideos auf ihren Inhalt analysiert. Die Studierenden haben wie Kim mit den Profilen fünf Stufen durchlaufen, bei denen sie versucht haben, gewisse Interessen auszudrücken, um so ihr Profil in vermeintlich jugendgefährdende Ecken der App zu „trimmen“. Bei zehn der Fake-Profile hat sich die Forschungsgruppe als volljährig ausgegeben, bei den restlichen 30 waren sie angeblich 13-jährige Nutzer*innen. So haben sie einen Vergleich gewonnen, wie sehr Tiktok Kinder auf der App schützt.

Wie wurde die Untersuchung durchgeführt?

Mit jedem dieser Profile wurden die gleichen fünf Stufen durchgeführt, um den Algorithmus bestmöglich auszunutzen. In zwei Eskalationsstufen haben die Studierenden mithilfe der Hashtagsuche versucht, dem Algorithmus bestimmte Interessen zu verdeutlichen. Zuerst mit harmlosen Hashtags wie „Fashion“, „Urlaub“ und „Dance“. In der zweiten Stufe dann eindeutige Hashtags, die so auf der Plattform üblich sind, wie „s3x“, „s3xy“, oder „seggs“ (diese sind mittlerweile für 13-Jährige gesperrt). Darüber hinaus wurde jeweils vor und nach diesen Suchen die ForYou-Page angesehen, um zu analysieren, wie diese sich verändert. Angesehen haben sie sich die ForYou-Page zuerst eine, dann zwei und später vier Minuten. Auch hier wurde, wie schon in den beiden „Hashtag-Phasen“, das Interesse an anstößig wirkenden Videos ausgedrückt, indem diese doppelt geschaut und gelikt wurden.

Wie wurden „sexuelle Inhalte“ definiert?

Bei der Definition von “sexuellen” Inhalten wurden neben den Inhalten der Videos auch die damit verbundene, mutmaßliche Intention der Urheber einbezogen. Nur selten wurden dabei Videos gesichtet, bei denen eine klare Gefährdung für Jugendliche naheliegt. Für diese Einschätzung wurden Expert*innen aus dem Feld des Jugendschutzes hinzugezogen. Der komplette Prozess der Profilerstellung und des Tiktok-Konsums wurde bei allen Profilen mit der Bildschirmaufnahme der Endgeräte aufgezeichnet, um die vermeintlich anstößigen Videos dann von Rechtsexpert*innen bezüglich möglicher Jugendgefährdung einordnen lassen zu können. Die Aufnahmen waren darüber hinaus für die weitere Analyse notwendig, da somit die ca. 3.000 einzelnen Clips noch einmal angeschaut und mithilfe eines eigens entwickelten Codebuchs kategorisiert werden konnten. Mit diesem Analyseprozess konnten die Studierenden im Verlauf der fünf Phasen die Veränderungen der Benutzeroberfläche nachvollziehen und zudem Profile mit verschiedenen Altersangaben vergleichend analysieren.

Quellen:

Experiment von Studierenden der TU Dortmund, Tiktok, Interview mit Michael Terhaag (Fachanwalt für IT-Recht, Düsseldorf), Interview mit Christian Montag (Psychologie-Professor, Universität Ulm), Interview mit Achim Lauber (Institut für Medienpädagogik), ARD/ZDF-Onlinestudie 2022

Autor*innen:

Emad Almansour, Yvonne Blaschke, Marcel Brandt, Leonard Brockes, Stella-Marie Hesch, Leon Hüttel, Kirsten Pfister, Katharina Roß, Henri Schlund und Anastasia Zejneli

Betreuung TU Dortmund:

Christina Elmer, Stephan Mündges

Redaktion ZDFheute:

Robert Meyer, Kevin Schubert

Im Auftrag des ZDF:

Design:

Jens Albrecht